The Debate – explaining the issues that matter

Todays Issue: The Whole Brain Emulation and the AI

Die Audiocasts von infpro sind urheberrechtlich geschützte Eigenwerke. Alle Inhalte wurden vom Redaktionsteam des Instituts für Produktionserhaltung (infpro) auf Grundlage eigener Publikationen (infpro Themenservice, infpro Magazin DIALOG, infpro The Debate, sowie Blogbeiträge auf infpro.org) erstellt. Es werden keine Texte Dritter kopiert, übernommen oder vertont.

Wenn Rechenzentren denken müssten

Warum die Debatte über Künstliche Intelligenz an der Realität von Energie, Infrastruktur und Produktivität vorbeiführt

Die Illusion immaterieller Intelligenz

Die öffentliche Debatte über Künstliche Intelligenz schwankt zwischen Euphorie und Untergangsrhetorik, zwischen versprochenem Produktivitätsschub und Warnungen vor einem Verlust menschlicher Autonomie. Auffällig ist, wie abstrakt sie oft geführt wird: KI erscheint als Code, Algorithmus, Idee. Tatsächlich ist sie vor allem eines: ein physisches, materielles Phänomen, dessen Leistungsfähigkeit an Energie, Flächenbedarf und reale Infrastruktur gebunden ist. Ohne diese Grundlagen bleibt sie ein Versprechen, keine Technologie mit systemischer Tragweite. „2025 könnte das Jahr sein, in dem Unternehmen den Ausgleich zwischen Geschwindigkeit und Verantwortung meistern müssen“, warnt eine Analyse zur breiten Einführung von KI-Systemen – und verweist damit zugleich auf die betriebswirtschaftlichen und regulatorischen Rahmenbedingungen, die mit dem Einsatz einhergehen müssen.

Energiehunger als ökonomischer Faktor

Wer verstehen will, was KI heute leistet und was nicht, kommt an einer nüchternen Analyse von Energie und Netzlast nicht vorbei. Schon stark vereinfachende Modellvergleiche zwischen biologischer und maschineller Informationsverarbeitung zeigen: Systeme, die in die Nähe menschlicher kognitiver Leistungsfähigkeit rücken, benötigen Extreme im Rechenbetrieb – mit Megawatt-Stromzufuhr und aufwendiger Kühlung. Diese Anforderungen machen KI-Infrastruktur zu einem relevanten energiepolitischen Faktor. Internationale Prognosen unterstreichen die Dimension dieses Trends: So erwartet die Internationale Energieagentur, dass der Strombedarf globaler Rechenzentren bis 2030 auf mehr als das Doppelte anwachsen wird, getragen vor allem durch KI-Anwendungen und datenintensive Dienste. Diese Entwicklung ist nicht nur technisch relevant, sondern ökonomisch: Rechenzentren entwickeln sich zu kritischer Infrastruktur, deren Energiebedarf schneller wächst als der vieler klassischer Industrien. Ohne massive Investitionen in Netze, Kraftwerke und Speicher lässt sich dieser Ausbau kaum realisieren. Wer KI als Produktivitätsmotor preist, ohne diese strukturellen Kosten zu bedenken, argumentiert unvollständig.

Zahlenspiele und Rebound-Effekte

Dabei bleiben Effizienzgewinne auf der Software- und Hardwareseite oft hinter dem gesteigerten Ressourcenbedarf zurück. Jede eingesparte Kilowattstunde wird durch häufigere Nutzung, größere Modelle oder zusätzliche Anwendungsfälle regelmäßig überkompensiert. Dieses Phänomen ist kein Randeffekt, sondern strukturelles Merkmal einer Technologie, die in vielen Bereichen gleichzeitig wachsen soll.

Eine aktuelle Prognose zeigt, dass allein der Stromverbrauch für KI-Rechenzentren bis 2030 auf das Mehrfache des heutigen Niveaus steigen dürfte, während sich auch der Kühlwasserbedarf vervielfacht. oeko.de Diese Zahlen sind keine technische Kuriosität, sondern ein wirtschaftlicher Parameter, der Investitions-, Standort- und Energiepolitik direkt betrifft.

Produktivität ohne Universalität

In klar abgegrenzten Aufgabenfeldern – Mustererkennung, Datenanalyse, Prozessoptimierung – steigert KI heute nachweislich Produktivität. Unternehmen berichten, dass sie durch KI Unterprozesse automatisieren und Kosten senken können. Doch diese Leistungsfähigkeit ist nicht universell übertragbar. Sie hängt von formalisierten Datenlagen, klaren Zielen und stabilen Rahmenbedingungen ab. In den Führungsetagen zeichnet sich daher ein pragmatisches Bild: „Die Technologie könnte vieles verändern, aber erst die realistische Einschätzung ihrer Grenzen wird ihre wirtschaftliche Einführung bestimmen“, schrieb Reuters kürzlich über die Haltung zahlreicher Unternehmen gegenüber dem KI-Boom. Aktuelle Stimmen aus Wirtschaft und Tech-Industrie belegen die massive Kapitaldeckung, die hinter dieser Infrastruktur steht: Mustafa Suleyman, CEO von Microsoft AI, erklärte im Dezember 2025, dass es „Hunderte von Milliarden Dollar kosten wird, um mit der Spitzentechnologie der KI in den nächsten fünf bis zehn Jahren mitzuhalten“

Diese Einschätzung unterstreicht, dass KI-Infrastruktur nicht nur Software ist. Sie ist Kapital, Energie, Netzkapazität – und damit ein Substrat, das Wirtschaftspolitik und Unternehmensstrategien direkt betrifft. Für die Wirtschaftspolitik folgt aus diesem Befund mehr als nur der Ruf nach „Digitalisierung“. Staaten stehen vor der Entscheidung, welche Sektoren bevorzugten Zugriff auf knappe Netz- und Erzeugungskapazitäten erhalten: kritische Versorgung, Grundindustrie – oder energieintensive Großrechenzentren. Förderprogramme ohne klare Priorisierung verlagern Kosten in andere Bereiche der Volkswirtschaft und verkennen Verteilungskonflikte. Zudem zeigt sich in Umfragen, dass die Öffentlichkeit diese Themen zunehmend wahrnimmt und eine stärkere Regulierung sowie mehr Transparenz fordert, gerade in Bezug auf Energie- und Wasserverbrauch der digitalen Infrastruktur.

Menschliche Urteilskraft als ökonomische Ressource

Über diese infrastrukturellen Fragen hinaus bleibt ein struktureller Unterschied zwischen Maschine und Mensch bestehen: Die kognitive Flexibilität, die Fähigkeit zur Einordnung in soziale und kulturelle Kontexte, lässt sich bislang nicht algorithmisch abbilden. Diese Unterscheidung ist kein romantischer Gegensatz, sondern ein wirtschaftlich relevanter Befund: Urteilskraft und Verantwortungsübernahme sind Ressourcen, die in Organisationen nicht substituierbar sind.

Die Zukunft der KI wird sich daher nicht in reiner Rechenleistung entscheiden, sondern in der Fähigkeit von Politik und Wirtschaft, Ordnungsfragen zu lösen. Die Verfügbarkeit von Energie, die Belastbarkeit von Netzen und die Fähigkeit, physische Infrastruktur zu planen und zu bauen, werden zu entscheidenden Parametern. Skeptisch, aber nicht resignativ lässt sich festhalten: Die wirtschaftlichen Potenziale der KI sind real, doch sie müssen in ein Ordnungsrahmenwerk eingebettet werden, das ihre Kosten internalisiert und klare Prioritäten setzt. Nur so wird aus dem Hype ein produktiver, nachhaltiger Beitrag zur Wirtschaft.

Die zentrale Frage der kommenden Jahre lautet daher nicht, ob Maschinen intelligenter werden als Menschen. Sie lautet, wie Wirtschaftspolitik und Unternehmensstrategien den Einsatz von Künstlicher Intelligenz so gestalten, dass sie Nutzen schafft, ohne Ressourcen vernachlässigt. Die Zukunft gehört nicht der maximalen Rechenleistung, sondern der richtigen Entscheidung, wann sie wirklich gebraucht wird.

Zwischen Emulation und Effizienz: Was Maschinen vom Denken trennt

Es gehört zu den Konstanten des technologischen Fortschritts, dass jede neue Rechenstufe alte Versprechen reaktiviert. Kaum wächst die verfügbare Rechenleistung, kaum sinken die Kosten für Speicher und Datenverarbeitung, meldet sich auch die Vision zurück, das menschliche Gehirn ließe sich bald vollständig technisch reproduzieren. Whole Brain Emulation, kurz WBE, heißt das Projekt, das seit Jahren zwischen Neurowissenschaft, Informatik und Transhumanismus zirkuliert. Die Sprache ist ambitioniert, die Zeitachsen oft optimistisch. Doch wie so häufig lohnt es sich, einen Schritt zurückzutreten und zu fragen, ob hier tatsächlich eine realistische Technologieagenda entsteht – oder ob eine intellektuell reizvolle Idee mit der ökonomischen und wissenschaftlichen Wirklichkeit kollidiert.

Der Anspruch der WBE ist klar formuliert. Wer das menschliche Gehirn mit ausreichender Auflösung erfasst, seine Struktur vollständig digitalisiert und die resultierenden Daten mit genügend Rechenleistung simuliert, könne Bewusstsein, Persönlichkeit und Denken in eine technische Umgebung überführen. In dieser Vorstellung liegt eine eigentümliche Ingenieurslogik: Was komplex genug modelliert wird, müsse sich zwangsläufig funktional ergeben. Genau hier beginnen jedoch die Probleme.

Schon die erste Voraussetzung, die vollständige Erfassung des Gehirns, erweist sich als erheblich anspruchsvoller, als es populäre Darstellungen nahelegen. Nicht-invasive Verfahren wie die Magnetresonanztomographie haben in den vergangenen Jahrzehnten enorme Fortschritte gemacht. Sie erlauben Einblicke in Aktivitätsmuster, funktionale Netzwerke und strukturelle Zusammenhänge. Für eine vollständige Emulation reichen diese Informationen jedoch bei weitem nicht aus. Synaptische Verschaltungen, subzelluläre Prozesse und chemische Signalwege bleiben weitgehend unsichtbar. In der einschlägigen WBE-Roadmap von Anders Sandberg bewegen sich diese Verfahren deutlich unterhalb jener Detailstufen, die für eine realistische Simulation erforderlich wären.

Invasive Verfahren verschieben die Grenze, lösen das Problem aber nicht. Elektronenmikroskopische Schnitte liefern beeindruckende Details, sind jedoch extrem zeit- und datenintensiv. Ein menschliches Gehirn mit rund 86 Milliarden Neuronen und schätzungsweise einer Billiarde Synapsen vollständig zu erfassen, würde selbst unter idealisierten Bedingungen Jahre in Anspruch nehmen. Hinzu kommen praktische Grenzen: biologische Veränderung während des Scanprozesses, Messrauschen, Artefakte. Vor allem aber bleibt offen, ob Struktur allein genügt. Denn das Gehirn ist kein statisches Objekt, sondern ein dynamisches System, dessen Funktionsweise sich im Zeitverlauf verändert.

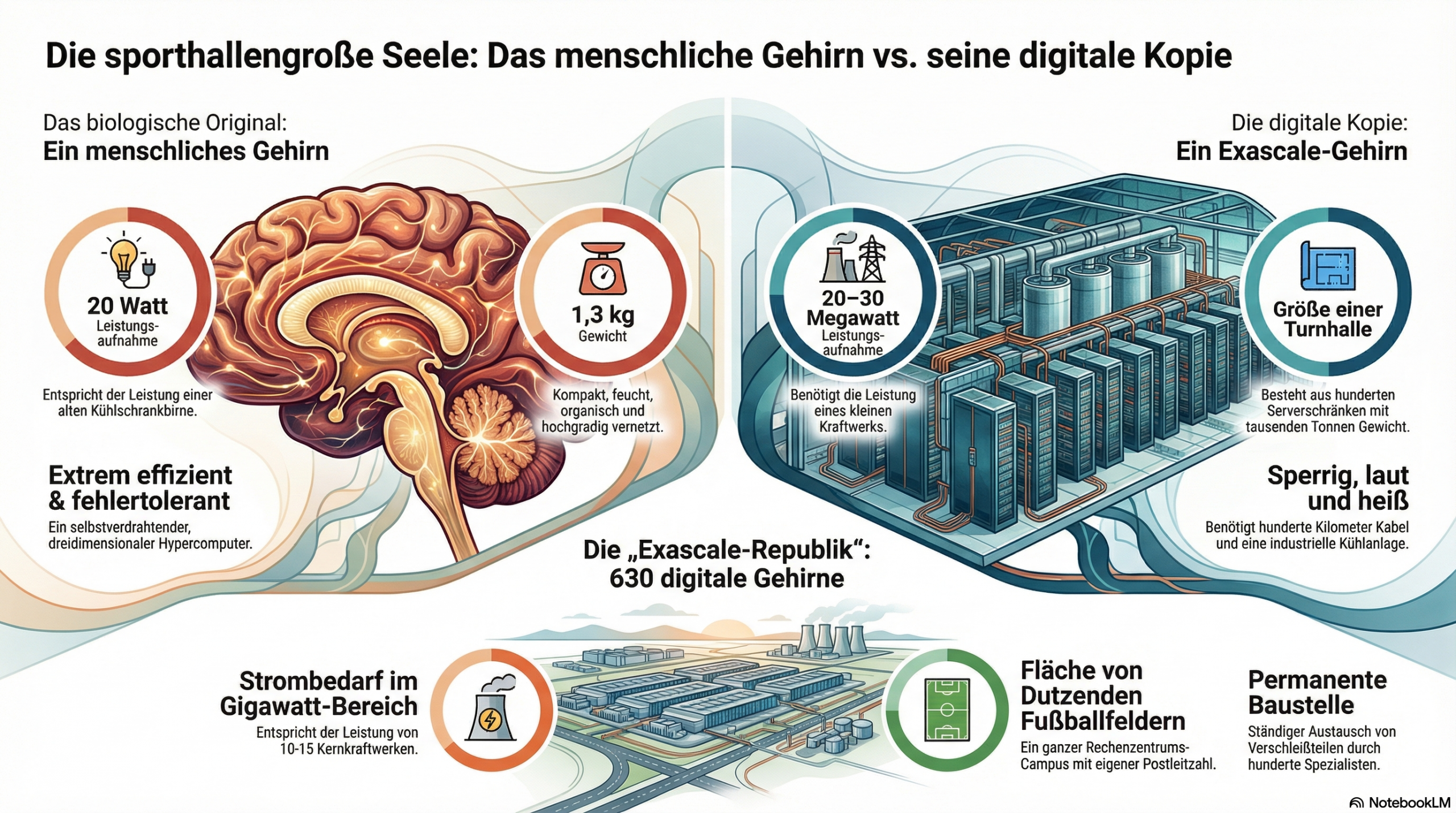

Damit ist die zweite Hürde erreicht: die Rechenleistung. Selbst stark vereinfachte Simulationen biologischer Nervensysteme verschlingen heute enorme Ressourcen. Eine realistische Emulation des menschlichen Gehirns müsste nicht nur neuronale Aktivität abbilden, sondern auch synaptische Plastizität, Neurotransmitter, Gliazellen, metabolische Prozesse und Rückkopplungseffekte berücksichtigen. Seriöse Schätzungen verorten den dafür notwendigen Rechenaufwand im Bereich von Exa- bis Zettaflops. Das liegt nicht nur jenseits heutiger Supercomputer, sondern auch außerhalb dessen, was ökonomisch vertretbar erscheint. Rechenleistung mag exponentiell wachsen, doch Energie, Kühlung und Infrastruktur folgen physikalischen und finanziellen Grenzen.

Noch schwerer wiegt jedoch ein Problem, das sich nicht durch Investitionen lösen lässt. Bis heute ist ungeklärt, welches Detailniveau für Bewusstsein entscheidend ist. Reicht die Verschaltung der Synapsen? Oder spielen Gliazellen, epigenetische Mechanismen und molekulare Zufälligkeiten eine konstitutive Rolle? Die Neurowissenschaft kennt zahlreiche Korrelationen zwischen Struktur und Funktion, aber keine vollständige Theorie des Bewusstseins. Wer emuliert, ohne zu verstehen, trifft zwangsläufig Annahmen. Diese Annahmen mögen plausibel sein, bleiben jedoch spekulativ. Das Ergebnis ist kein digitales Gehirn, sondern ein Modell, dessen ontologischer Status ungeklärt bleibt.

Vor diesem Hintergrund wirkt es fast paradox, dass die Künstliche Intelligenz zeitgleich erhebliche Fortschritte erzielt – ohne den Anspruch, dem Gehirn strukturell zu ähneln. Moderne KI-Modelle verzichten bewusst auf biologische Treue. Sie abstrahieren, optimieren und skalieren. Ihr Erfolg ist empirisch messbar. In klar definierten Aufgaben übertreffen sie den Menschen bereits heute: in der Mustererkennung, in der Datenanalyse, in Teilen der Programmierung. Der Weg dorthin ist jedoch grundlegend anders als der der WBE.

Während die Emulation versucht, das biologische Original zu kopieren, geht KI den umgekehrten Weg. Sie fragt nicht, wie das Gehirn arbeitet, sondern welche Funktionen sich technisch effizient reproduzieren lassen. Dieser funktionale Ansatz hat Konsequenzen. KI-Systeme benötigen enorme Energiemengen, insbesondere im Training. Sie sind abhängig von großen Datenbeständen und klar formulierten Zielvorgaben. Ihre Generalisierungsfähigkeit ist begrenzt, ihre Fehler oft schwer vorhersehbar. Und doch haben sie sich als wirtschaftlich relevant erwiesen.

Der Vergleich mit dem menschlichen Gehirn fällt ernüchternd aus – für beide Seiten. Das Gehirn bleibt in seiner Energieeffizienz unerreicht. Mit etwa 20 Watt bewältigt es Wahrnehmung, Lernen, Planung und soziale Interaktion. Es generalisiert aus wenigen Beispielen, integriert Emotionen und Kontext, passt sich kontinuierlich an. KI-Systeme hingegen verbrauchen im Training oft Hunderte Kilowatt, erreichen dafür aber Geschwindigkeiten und Skaleneffekte, die biologisch nicht möglich sind. Wo der Mensch mit Erfahrung reagiert, rechnet die Maschine.

In der öffentlichen Debatte werden diese Unterschiede häufig verkürzt. Entweder wird KI als baldiger Ersatz menschlicher Intelligenz stilisiert oder das Gehirn als prinzipiell unerreichbares Ideal verklärt. Beides greift zu kurz. Tatsächlich handelt es sich um zwei unterschiedliche Formen von Intelligenz, die sich nur begrenzt vergleichen lassen. Die Maschine ist überlegen, wo Aufgaben formalisiert und Daten reichlich vorhanden sind. Der Mensch bleibt überlegen, wo Unsicherheit, Kontext und soziale Dynamik dominieren.

Für Wirtschaft und Politik ist diese Unterscheidung von erheblicher Bedeutung. Investitionsentscheidungen folgen nicht philosophischen Visionen, sondern belastbaren Zeithorizonten. Die vollständige Emulation des Gehirns mag ein langfristiges Forschungsziel sein, sie ist jedoch kein realistischer Hebel für Produktivität, Wettbewerbsfähigkeit oder Standortpolitik. Wer Ressourcen in dieser Hoffnung bindet, setzt auf ein Projekt mit unklarer Rendite und offenem Erkenntnisstand.

Ganz anders verhält es sich bei der Künstlichen Intelligenz. Ihre Grenzen sind bekannt, ihre Stärken messbar. Sie lässt sich in bestehende Wertschöpfungsketten integrieren, skaliert international und folgt ökonomischen Anreizen. Der gegenwärtige Fortschritt resultiert nicht aus metaphysischen Annahmen, sondern aus einer nüchternen Kombination von Daten, Algorithmen und Hardware. Dass diese Systeme nicht „verstehen“ wie Menschen, ist kein Makel, sondern Teil ihres Designs.

Die eigentliche Gefahr liegt daher weniger in der Leistungsfähigkeit der Maschinen als in falschen Erwartungen. Wer glaubt, Bewusstsein lasse sich kurzfristig technisch konservieren, unterschätzt die Komplexität biologischer Systeme. Wer hingegen erwartet, KI werde den Menschen vollständig ersetzen, verkennt die Grenzen funktionaler Modelle. Fortschritt entsteht nicht durch Gleichsetzung, sondern durch Arbeitsteilung.

Am Ende bleibt eine nüchterne Einsicht. Der technologische Fortschritt folgt selten der elegantesten Idee, sondern der praktikabelsten. Die große Abkürzung über das Gehirn ist intellektuell verführerisch, ökonomisch jedoch kaum tragfähig. Die Maschine wird den Menschen nicht kopieren. Sie wird ihn ergänzen – dort, wo Berechnung zählt, und gerade nicht dort, wo Erfahrung, Urteil und Verantwortung gefragt sind. Wer das akzeptiert, gewinnt einen realistischeren Blick auf die Zukunft der Intelligenz. Wer es ignoriert, riskiert, an einer Idee festzuhalten, deren Zeit noch nicht gekommen ist – und deren Nutzen ungewiss bleibt.